Google のマルチモーダル生成AI「Gemini」でできることや、ChatGPT との比較を 5 分で解説

こんにちは、クラウドエース編集部です。

本記事では、2023 年 12 月 6 日(米国時間)に発表されたばかりの Google のマルチモーダル生成AI 「Gemini」について概要や使い方、ChatGPT との比較について 5 分で読める内容にまとめて解説していきたいと思います。

Gemini とは

Google が 2023 年 12 月 6 日 に発表した「Gemini」は、最先端のマルチモーダル生成AI モデルです。このモデルはテキスト、画像、音声、動画、コードなど、複数のデータタイプを理解し、それらを組み合わせて操作する能力を持っています。これにより、これまでの生成AI モデルが苦手としていた複雑なタスクにも対応できるようになりました。

Gemini は 3 つのモデルで展開される予定です。

- Gemini Ultra・・・非常に複雑なタスク、特に推論やマルチモーダルなタスクを含む幅広い分野で、最高レベルの性能を発揮するモデルです

- Gemini Pro・・・コストとレイテンシーの両面で最適化された幅広いタスクに対応する汎用性の高いモデル

- Gemini Nano・・・モバイルデバイスなどのオンデバイスタスクに最適化された効率的なモデル

Gemini で可能になること -マルチモーダルとは

Gemini は、そのマルチモーダルな能力により、多岐にわたる業界で革新的な変化をもたらすことが期待されています。

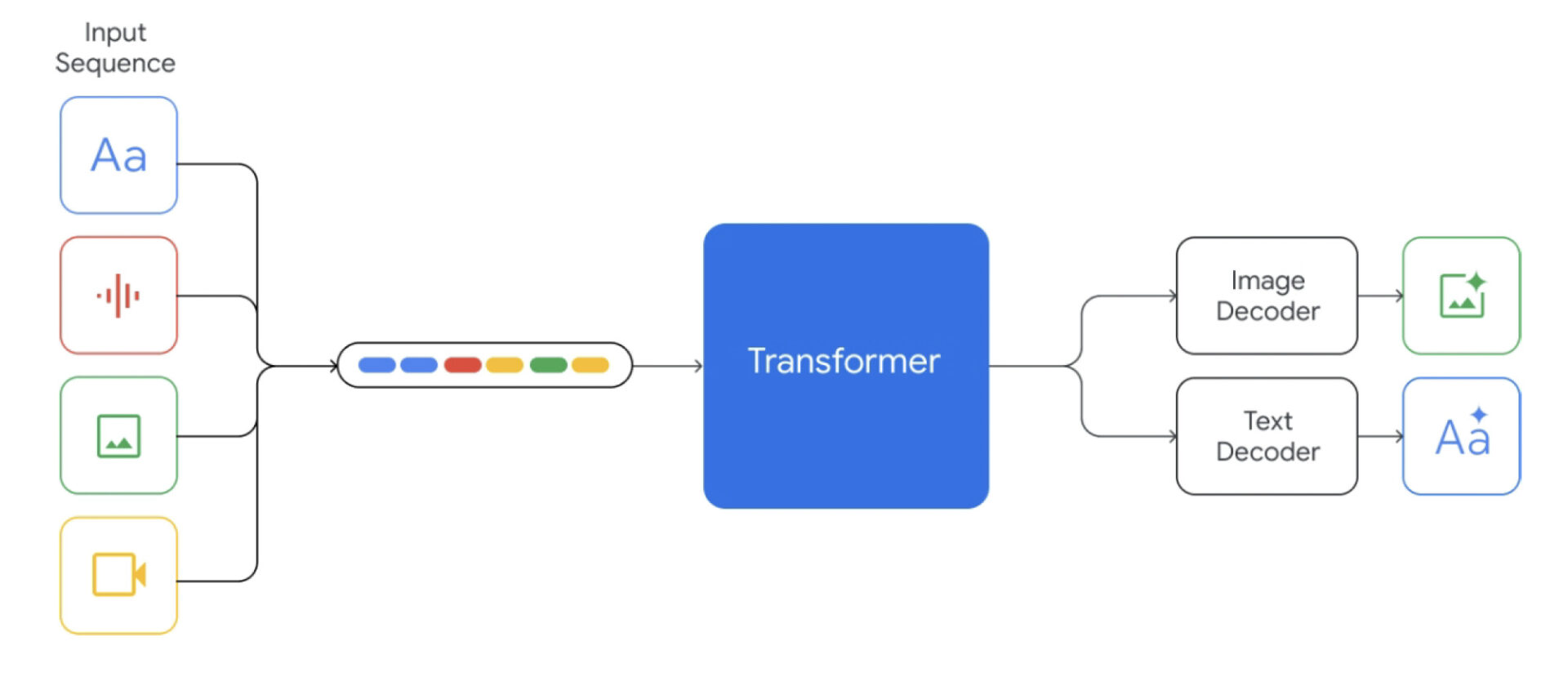

マルチモーダルとは、複数の種類のデータを同時に扱うことができるAIの能力のことを指します。Gemini はこれらのデータタイプを一から学習し、マルチモーダルデータを使用してより洗練された生成を可能にします。

入力として、文章・音声・画像・動画等を、出力として文章と画像を交差的(Interleave)に扱える点は他の生成AI にはない大きな特徴と言えます。

画像引用元 https://storage.googleapis.com/deepmind-media/gemini/gemini_1_report.pdf(Google DeepMind)

また、複雑な文書の要約やインサイトの抽出、テキストや画像に基づく複雑な問題への回答、さらには高度なプログラミングコードの生成といったタスクも、Gemini の高度な推論能力によって可能になります。特に、科学研究や金融分析のような分野では、膨大な量のデータから必要・重要な情報だけを抽出することができるようになります。

さらに、Gemini はモバイルデバイス上でのタスクにも最適化される予定で、音声認識や画像処理など、日常的なアプリケーションの性能を飛躍的に向上させ、私たちの生活をより便利で生産的なものにしてくれることが期待できます。

Gemini と ChatGPT の違いや比較

2023 年 9 月に発表された、GPT-4V に代表されるように、ChatGPT もマルチモーダルタスクを扱うことが可能です。ただし、内部的な実装がどうなっているかについては公表はされていません。既存技術を組み合わせる(例えば、画像を OCR して文字列化する機能と、それを LLM に解釈させる機能といった) ことでマルチモーダルを実現していることも考えられます。

それに対し、 Gemini はマルチモーダルな情報を扱うことを前提に根本から設計されており、トレーニング段階からマルチモーダルのデータセットを使って学習させることで、入力と出力でネイティブにマルチモーダルな情報を取り扱えるモデルになっています。

“Gemini models are trained to accommodate textual input interleaved with a wide variety of audio and visual inputs, such as natural images, charts, screenshots, PDFs, and videos, and they can produce text and image outputs (see Figure 2). The visual encoding of Gemini models is inspired by our own foundational work on Flamingo (Alayrac et al., 2022), CoCa (Yu et al., 2022a), and PaLI (Chen et al., 2022), with the important distinction that the models are multimodal from the beginning and can natively output images using discrete image tokens (Ramesh et al., 2021; Yu et al., 2022b).”

参照元 https://storage.googleapis.com/deepmind-media/gemini/gemini_1_report.pdf(Google DeepMind)

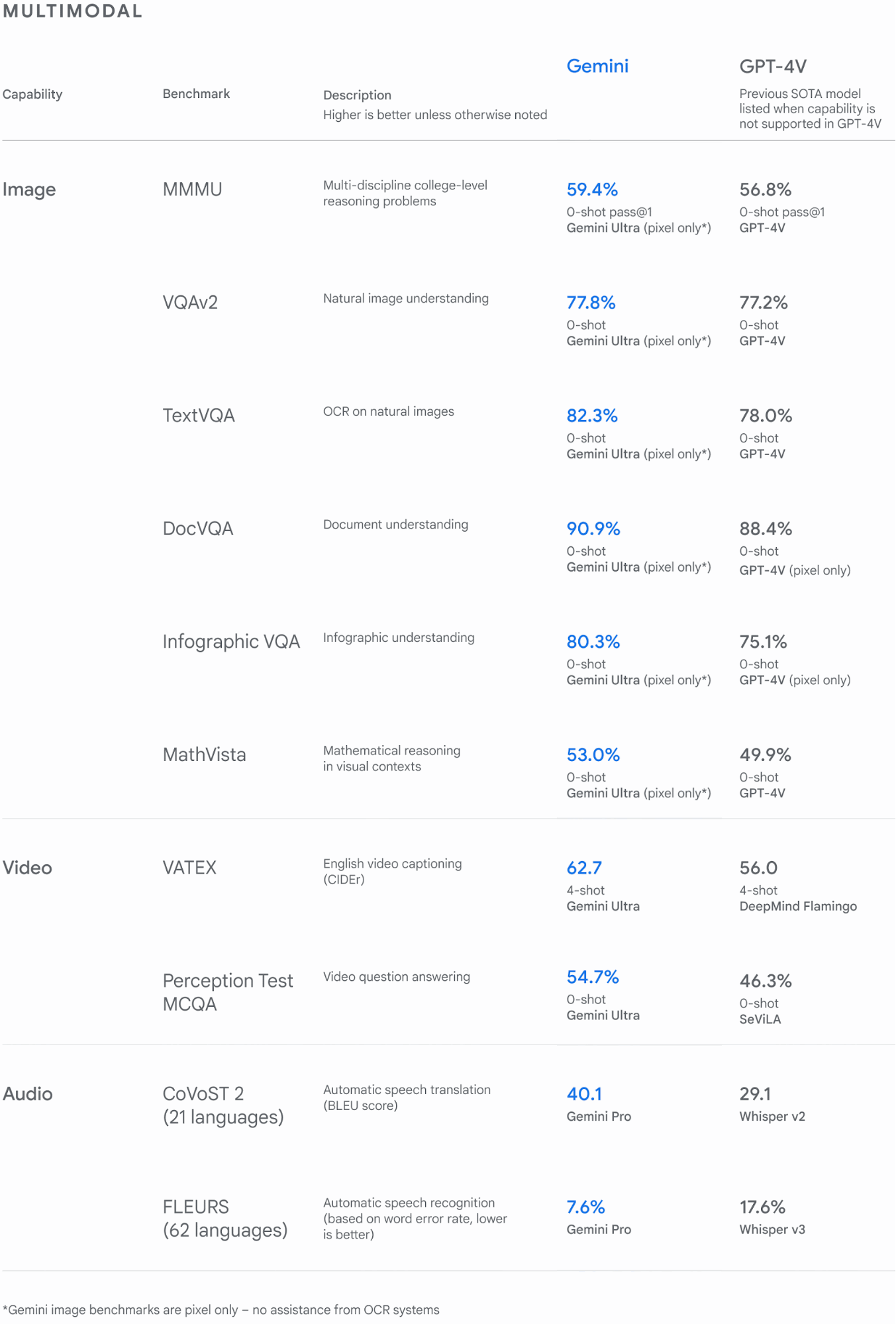

また、Google の人工知能研究所である Google DeepMind の公式ウェブサイトに掲載されているマルチモーダルタスクとテキストタスクの処理性能について、Gemini と GPT4 のベンチマークテストを紹介していきたいと思います。

Gemini のマルチモーダル性能は、特に画像認識タスク(VQA2、TextVQA)で GPT-4 をわずかに上回り、ドキュメント理解(DocVQA)で 2.5% 以上の差を見せます。一方、ビデオキャプション(VATEX)では Gemini が約 6.7 ポイント高く、音声翻訳(CoVoST 2)では Gemini Pro がGPT-4 の Whisper v2 より 10.2 ポイント高い結果を示しています。

画像引用元https://deepmind.google/technologies/gemini/#capabilities

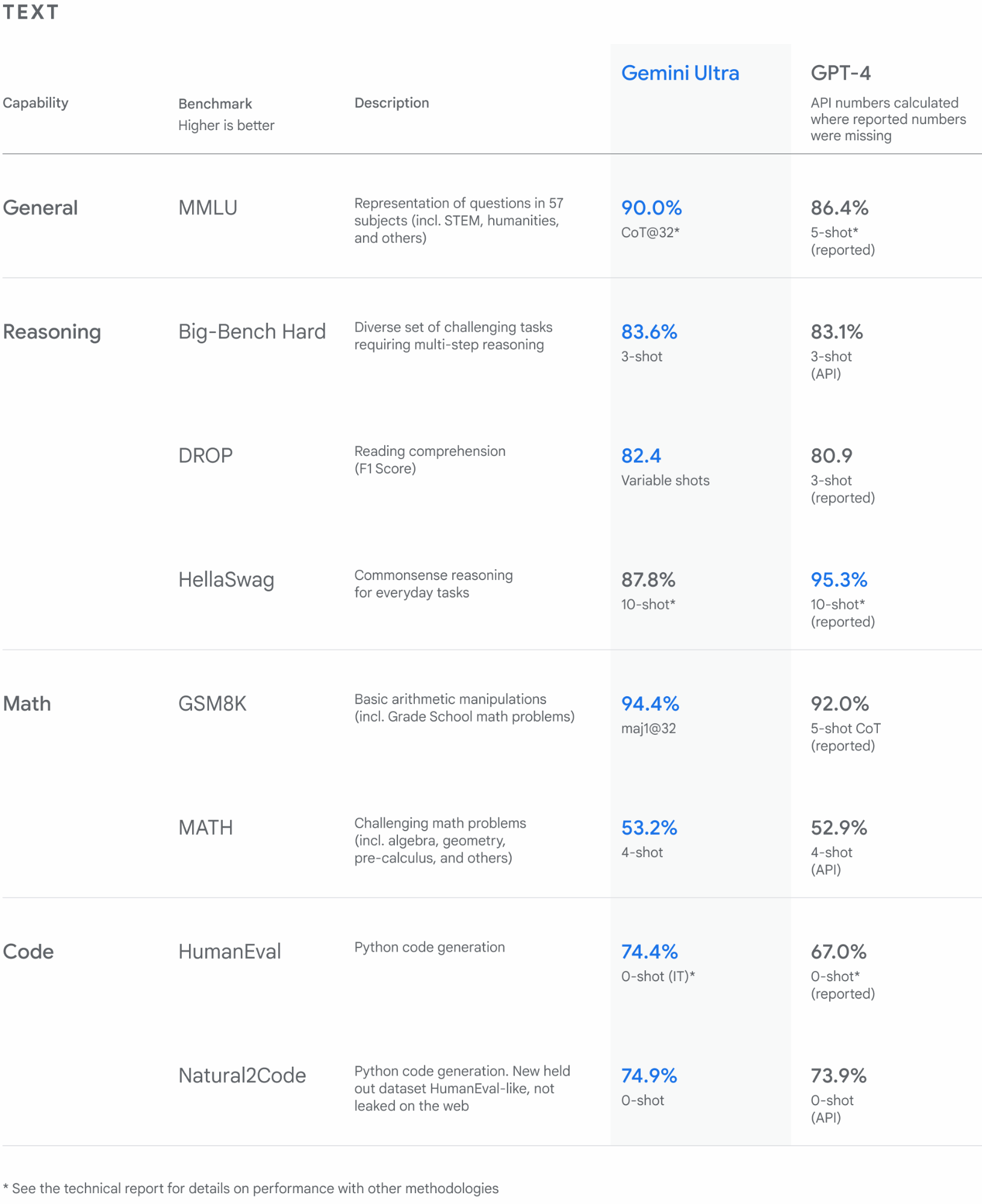

テキストベースのベンチマークでは、Gemini Ultra が一般的な知識(MMLU)、推論(Big-Bench Hard)、読解(DROP)の各タスクで GPT-4 を凌ぎますが、常識推論(HellaSwag)では GPT-4 が上位です。数学(GSM8K)では両者が近い結果を示し、コード生成(HumanEval、Natural2Code)では Gemini がより高い精度を示しています。

HellaSwagのスコアではGPT-4より悪い結果となっていますが、テクニカルレポート(https://storage.googleapis.com/deepmind-media/gemini/gemini_1_report.pdf)では、データ汚染の可能性が指摘されています。

MMLU は LLM の総合的なベンチマークと言われていますが、特定分野における人間の専門家が 89.8% と言うデータがあり(参照:https://arxiv.org/abs/2009.03300 )、これを世界で初めて超える 90.0% というテストデータを記録しました。

つまり、医学も物理も数学も法律も、その他のあらゆる分野においても専門家以上の知識と課題解決力をもったスーパーマンのような AI が登場したと言っても過言ではありません。

MMLU・・・AI モデルの知識と問題解決能力をテストする最も一般的な方法の 1 つ

参照:https://deepmind.google/technologies/gemini/#capabilities

画像引用元 https://deepmind.google/technologies/gemini/#capabilities

結論として、ほぼ全てのタスク項目において Gemini が GPT-4、GPT-4V を上回っていることがわかりました。

特にマルチモーダルタスクの処理については、高いポテンシャルを持っていると言えます。

Gemini の今後の計画、使い方について

Gemini は、今後 Google のさまざまな製品やサービスに統合され、ユーザーが直接触れることができる多くの接点が生まれます。

Google 各種サービス(順次対応)

Gemini は Google 検索と広告に組み込まれ、検索結果の精度と関連性を向上させることで、ユーザー体験を改善します。また、広告のパーソナライズやコンテンツの最適化にも活用されることが予想されます。Chrome、Duet AI、Google マップなどでも利用できるようになる予定です。

Google Pixel

Google Pixel シリーズの最新モデル Pixel 8 Pro では、Gemini Nano がオンデバイスで動作し、ユーザーに新しい体験を提供できるように設計されています。例えば、音声認識や写真の自動整理、効率的なコミュニケーション支援が可能になります。

Google Bard

Bard に Gemini Pro を統合することで、ユーザーはより高度な会話型AI を利用して、文章の編集やブレインストーミング、計画立案などを行えるようになります。これは、ユーザーがより創造的で効率的な作業を行えるよう支援します。また、今後数か月以内にさまざまなマルチモーダルデータへの拡大、新しい地域や言語も追加対応される予定です。2024 年中には、Gemini Ultra を統合し、最先端の AI 体験を提供する Bard Advanced もリリース予定です。

※英語版の Bard は 2023 年 12 月 6 日より 170 以上の国と地域で公開されています。

開発者向け API(2023 年 12 月 13 日リリース)

Google AI Studio や Vertex AI を通じて提供される Gemini API により、開発者は独自のアプリケーションやサービスに Gemini Pro を組み込むことができます。これにより、開発者はユーザーに対してよりリッチでインテリジェントな機能を提供することが可能になります。

まとめ

Google の Gemini の登場で、生成AI の活用はマルチモーダルを中心とした次のステージに進化していくことでしょう。日本でも間もなく利用可能になると思いますので、引き続き注目していただけたらと思います。

参照:https://japan.googleblog.com/2023/12/gemini.html

※Google、Chrome、Google Pixel および Google マップは、Google LLC の商標です。